Agence Scraping

Le Web Scraping consiste à extraire de manière automatisée des données issues d'une ou plusieurs sources sur internet. Les usages du scraping sont très nombreux et peuvent présenter de nombreux avantages pour les entreprises.

Notre offre de Scraping

Le Web Scraping consiste à extraire de manière automatisée des données issues d'une ou plusieurs sources sur internet. Les usages du scraping sont très nombreux et peuvent présenter de nombreux avantages pour les entreprises.

• Surveiller automatiquement les prix d'un ou plusieurs produits concurrents en temps réel

• Extraire des avis en ligne pour alimenter des modèles d'IA sur mesure

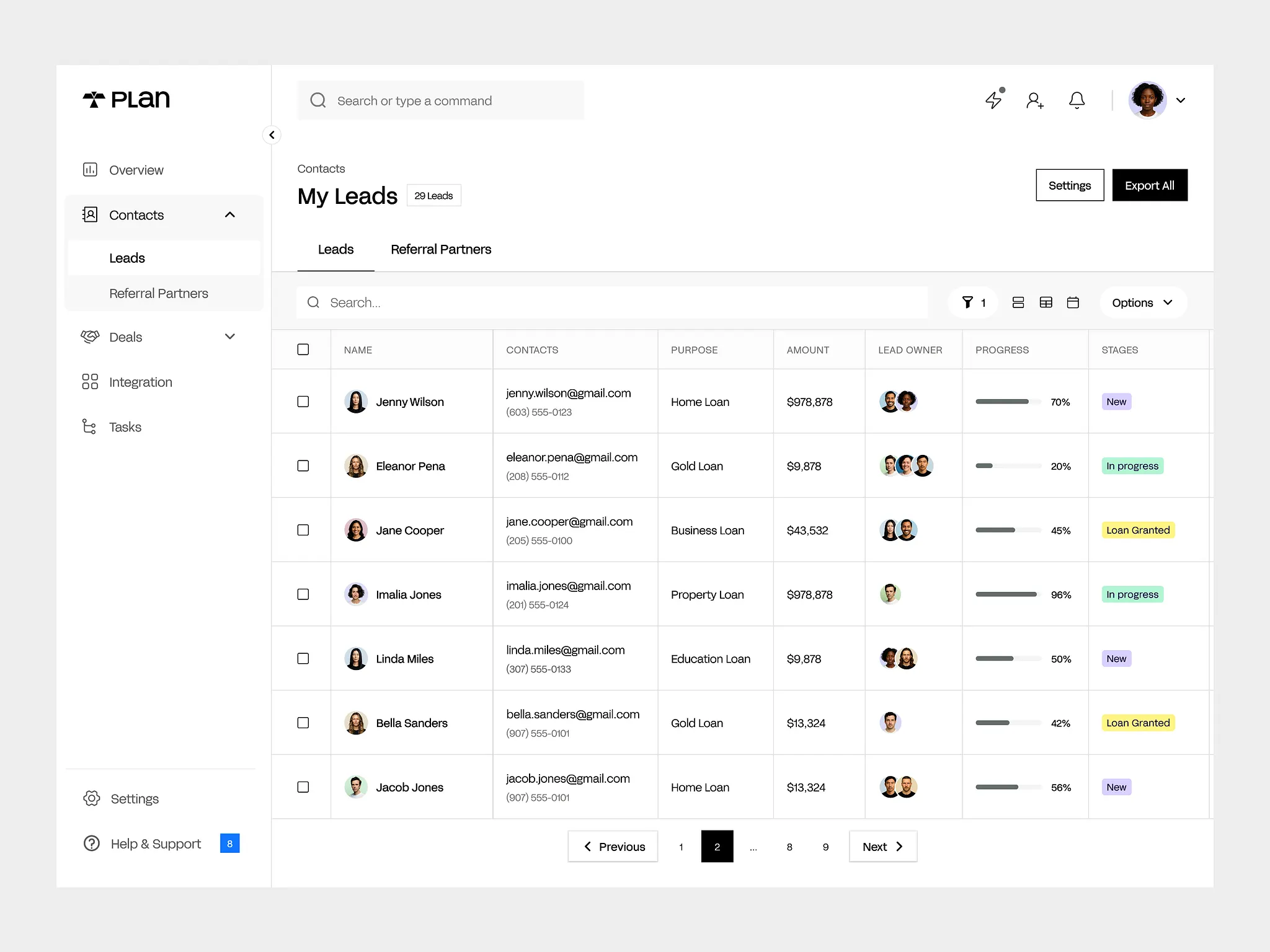

• Constituer des bases de leads qualifiés pour alimenter sa prospection

• Identifier les technologies et outils utilisés par des entreprises pour leur proposer des services adaptés

• Et de nombreux autres cas d'usages !

Faire appel à une agence scraping comme Terros permet de réduire considérablement la complexité et les délais associés à la mise en place de programmes de scraping.

Notre approche

Expertise technique avancée

Notre équipe maîtrise le contournement des protections anti-bot les plus sophistiquées (Cloudflare, PerimeterX, Akamai...). Nous gérons des gros volumes avec un déploiement de scrapers sur des infrastructures cloud stables et scalables.

Nous automatisons également les authentifications complexes si nécessaire, avec génération de tokens multi-étapes et analyse approfondie des systèmes de connexion.

Conformité & déontologie

Nous garantissons un respect strict du RGPD et des bonnes pratiques. Notre orchestration raisonnée des requêtes ne surcharge pas les serveurs cibles. Nous adoptons une approche responsable de la collecte de données, en totale conformité avec les réglementations en vigueur.

Formats livrables flexibles

Nous proposons des exports adaptés à vos besoins :

• Export CSV, JSON pour analyse dans vos outils existants

• API temps réel pour intégration directe dans vos systèmes

• Intégration directe dans vos outils d'analyse (CRM, BI, bases de données)

• Livraison ponctuelle ou flux continu selon vos besoins opérationnels

Analyse IA des données collectées

Au-delà de la simple extraction, nous proposons des services d'analyse avancée :

• Intégration dans des outils d'analyse sémantique SaaS ou on-premise (OpenWebUI, Langchain...)

• Pipelines d'analyse automatisés pour extraction d'insights : sentiment analysis, détection de tendances, clustering thématique

• Constitution de bases de connaissances interrogeables en langage naturel pour vos équipes

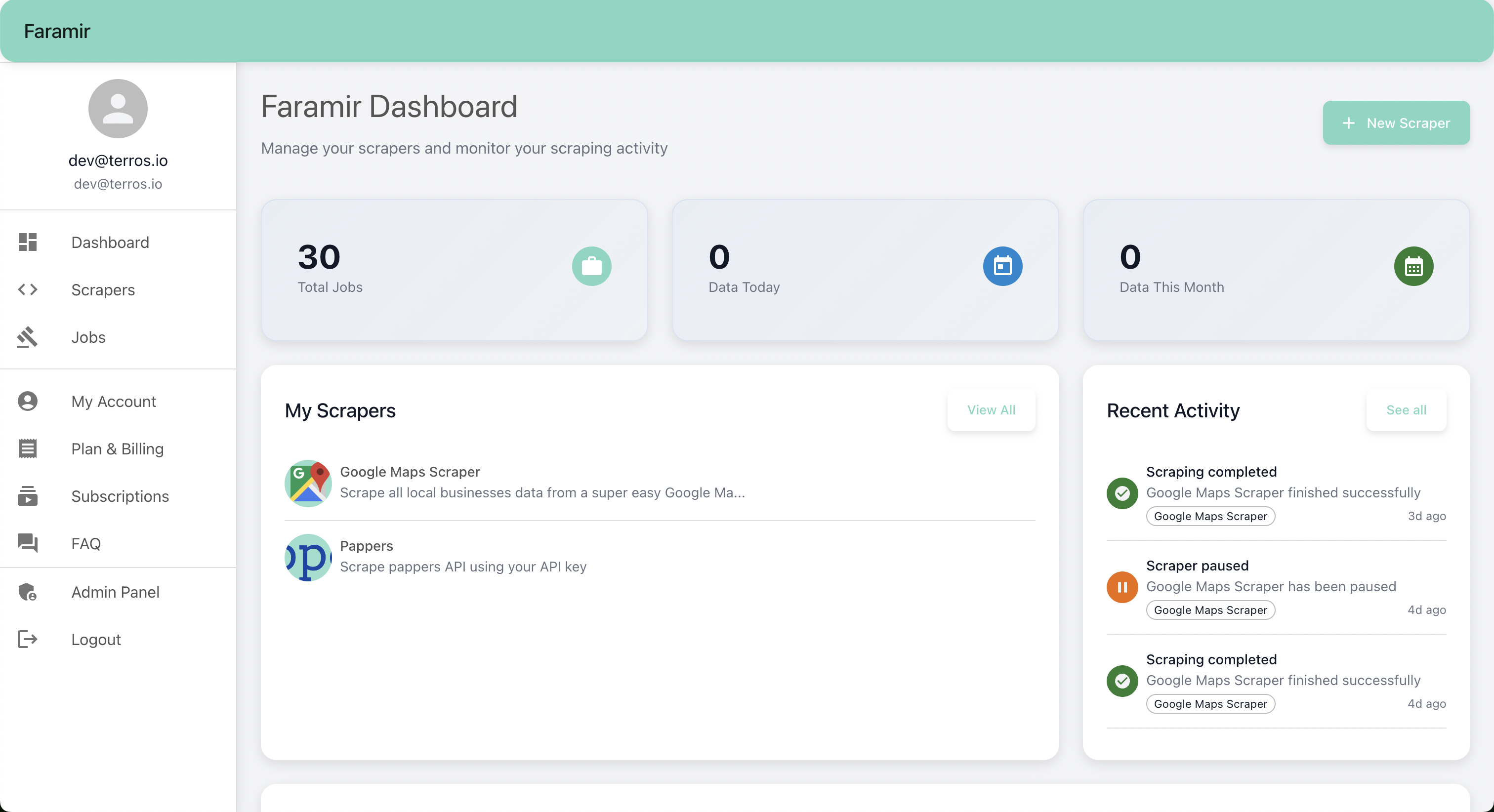

Faramir : votre plateforme SaaS de scraping en autonomie

Nous avons créé Faramir (https://app.faramir.io/), une plateforme SaaS qui permet à nos clients d'accéder en totale autonomie à leurs scrapers, qu'ils soient sur étagère ou développés sur mesure. Vous pouvez ainsi gérer vos extractions, planifier vos collectes et monitorer vos scrapers directement depuis une interface intuitive.

Notre méthode de développement en Scraping

La mise en place d'algorithmes de Web Scraping nécessite un audit préalable minutieux ainsi qu'une compréhension des besoins en extraction de données.

Compréhension du besoin et de l'objectif

Notre équipe d'experts en Web Scraping et Products Managers analyse votre besoin et les différentes caractéristiques de votre activité pour proposer un scénario d'automatisation, vous permettant de comprendre et de contribuer aux différentes étapes du projet, son budget et son planning.

Identifications des sources les plus pertinentes

À partir de l'identification de votre besoin, nous établissons avec vous une liste des sources Web les plus pertinentes à cibler.

Audit détaillé

Il est essentiel de réaliser un audit des sources avant de mettre en place un ou plusieurs processus de Web Scraping afin de garantir la légalité, l'éthique et la viabilité technique de la collecte de données.

Un audit approfondi permet d'évaluer la conformité juridique avec les lois et les conditions d'utilisation des sites ciblés, d'identifier les limitations techniques potentielles, et de s'assurer que le Web Scraping respecte les normes éthiques et les bonnes pratiques. En comprenant les caractéristiques des sources, on minimise les risques juridiques, techniques et éthiques, et on s'assure d'une collecte de données efficace et responsable.

Conception de l'architecture de données

Notre équipe d'architectes assure la planification de la structure dans laquelle les données collectées seront stockées. Cela inclut la définition des types de données, des relations entre les entités, et le choix des bases de données ou des systèmes de stockage adaptés.

Une conception réfléchie de l'architecture de données garantit une organisation efficace, une récupération facilitée des informations et une gestion optimale du volume croissant de données collectées via le web scraping.

Prototypage et développement

Des scripts de scraping initiaux sont élaborés pour tester la faisabilité technique et évaluer la qualité des données extraites.

Dans la phase de développement, ces prototypes sont améliorés, optimisés et adaptés pour être robustes face aux changements potentiels sur les sites ciblés. Cette étape est cruciale pour assurer la fiabilité et la stabilité du processus de Web Scraping tout en respectant les contraintes éthiques et légales.

Déploiement et suivi

Notre équipe de DevOps formée aux problématiques spécifiques du Scraping assure si nécessaire le déploiement des différents modules de Web Scraping développés sur une architecture Cloud adaptée.

Ce déploiement permet par exemple d'assurer une extraction régulière et autonome de données pour garantir un suivi permanent des sources ciblées et l'alimentation continue de bases de données variées : listes de prospects, matrices de prix, modèles de machine learning...

Notre équipe d'experts Scraping

En tant qu'agence Scraping, nous mettons à votre disposition notre équipe d'experts polyvalents et adeptes des dernières technologies pour concevoir des solutions Scraping sur mesure.

Jeremy

Product Manager – Ecommerce specialist

Salima

Développeuse FullStack

Alexandre

Lead Developer

Augustin

Architecte Développeur

Ayoub

Développeur IA

Nos réalisations Scraping

Découvrez comment nous avons aidé nos clients à transformer leurs processus grâce au Scraping

Avantages et inconvénients du Scraping

Découvrez les points forts et les défis du Scraping

Avantages ✅

Précision et cohérence

Les robots de scraping éliminent les erreurs humaines et garantissent une collecte de données cohérente et précise, même sur de très gros volumes.

Efficacité et gain de temps

Le scraping permet d'automatiser la collecte de données qui prendrait des heures ou des jours à faire manuellement, libérant ainsi du temps pour des tâches plus stratégiques.

Évolutivité

Le scraping peut traiter des milliers de pages simultanément, permettant de collecter des données à grande échelle de manière efficace.

Inconvénients ❌

Légalité et éthique à maîtriser

Le scraping doit respecter les conditions d'utilisation des sites et les réglementations en vigueur (RGPD, droits d'auteur). Une mauvaise pratique peut entraîner des conséquences juridiques.

Complexité technique

Le développement de robots de scraping nécessite une expertise technique avancée et une maintenance constante pour s'adapter aux changements des sites ciblés.

Ressources utilisées et Coût

Le scraping intensif peut consommer beaucoup de ressources serveur et de bande passante, générant des coûts d'infrastructure importants pour traiter de gros volumes de données.

Questions fréquentes sur le Scraping

Tout ce que vous devez savoir sur nos services Scraping