Services

Technologies

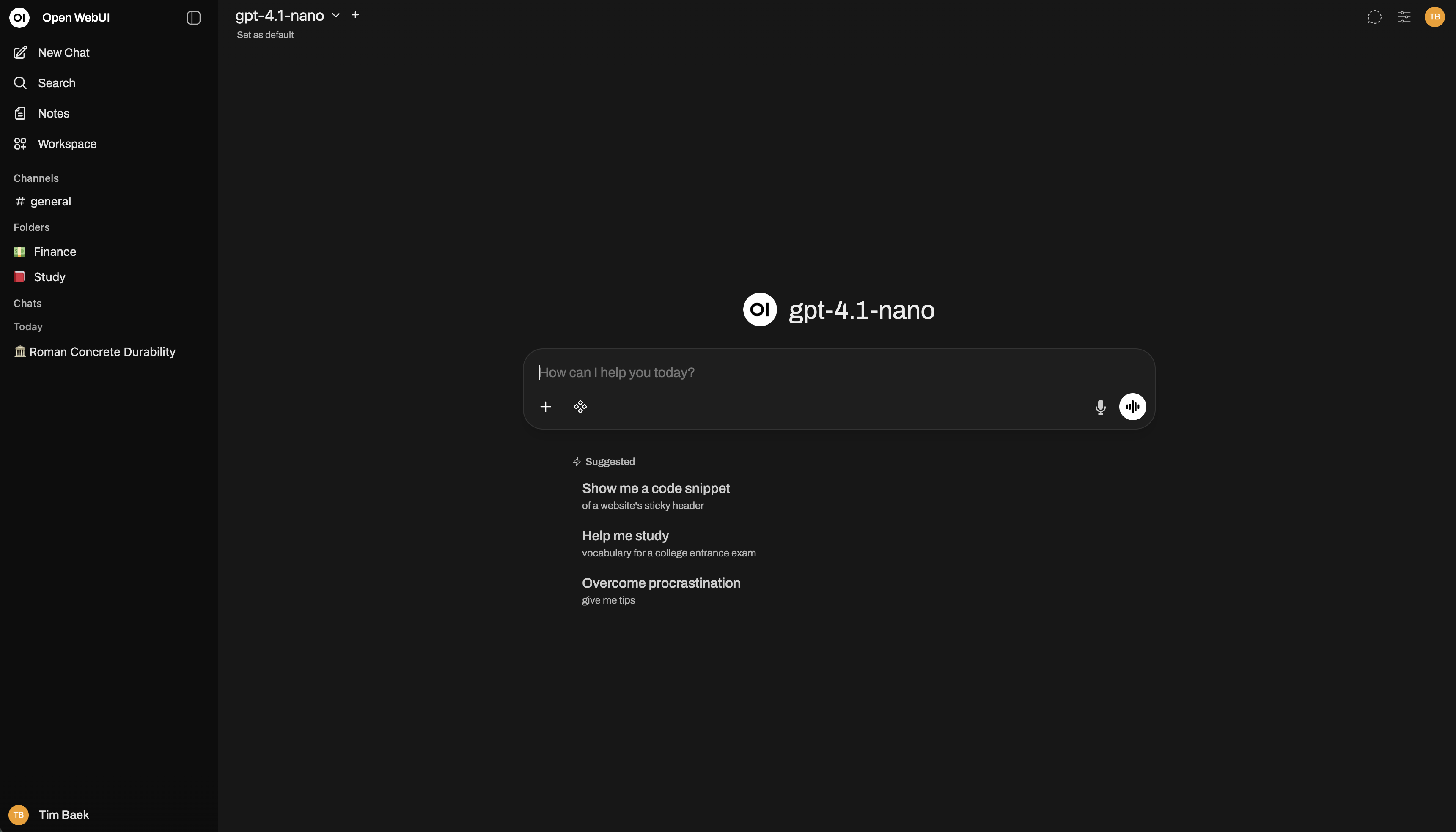

Paramétrages OpenWebUi pour dialoguer avec des bases documentaires propriétaires

Configuration et optimisation d'OpenWebUI pour permettre des conversations intelligentes avec des bases documentaires propriétaires. Audit technique approfondi et paramétrage avancé des modèles d'embedding, recherche vectorielle et reranking.

Contexte du projet

MPH1865, un leader industriel, souhaitait configurer OpenWebUI pour dialoguer intelligemment avec une base documentaire propriétaire. L'objectif était de permettre à une IA conversationnelle de comprendre et récupérer les informations pertinentes à partir de documents techniques complexes.

Cependant, la configuration initiale empêchait le système de fonctionner efficacement. Par exemple, lorsque les utilisateurs posaient des questions sur des concepts techniques spécifiques, le système ne parvenait pas à récupérer les sections de documents les plus pertinentes. Les résultats de recherche étaient souvent non pertinents ou incomplets, rendant difficile la recherche d'informations pour les utilisateurs.

Les principaux défis incluaient :

Les requêtes contournaient complètement la base vectorielle, s'appuyant uniquement sur la correspondance de mots-clés

Les documents n'étaient pas correctement segmentés, conduisant à une mauvaise extraction du contexte

Le modèle d'embedding était trop limité pour capturer les relations sémantiques entre les concepts

Les résultats de recherche étaient lents et manquaient de précision pour la documentation technique

Solution

Nous avons effectué un audit technique complet de la configuration OpenWebUI et mis en place une série d'optimisations pour transformer le système en un outil d'IA conversationnelle efficace pour les bases documentaires.

Notre approche s'est concentrée sur trois domaines clés :

1. Activation de la recherche sémantique

Nous avons désactivé le mode "Bypass Embedding & Retrieval", permettant aux requêtes d'exploiter pleinement la recherche vectorielle. Cela a permis au système de comprendre le sens sémantique des questions, pas seulement de faire correspondre des mots-clés. Par exemple, une requête sur "méthodes de traitement de données" récupère désormais correctement les documents discutant de "techniques de transformation de données" ou "approches de traitement de l'information".

2. Optimisation du traitement des documents

Nous avons affiné la stratégie de découpage des documents à 400 / 50, garantissant que chaque segment de document contient suffisamment de contexte tout en restant ciblé. Cela signifie que lorsque les utilisateurs posent des questions sur un concept spécifique, le système peut récupérer le paragraphe ou la section exacte qui contient l'information pertinente, plutôt que de renvoyer des documents entiers.

Nous avons amélioré le modèle d'embedding d'un modèle à 384 dimensions vers OpenAI text-embedding-3-small (1536 dimensions). Cela a considérablement amélioré la capacité du système à comprendre les relations nuancées entre concepts. Par exemple, il peut maintenant distinguer entre "authentification API" et "authentification utilisateur" même lorsque les deux termes apparaissent dans des contextes similaires.

3. Amélioration des performances de recherche

Nous avons mis en place une recherche hybride combinant BM25 (basé sur mots-clés) et recherche vectorielle (sémantique), avec un poids BM25 à 0,5. Cette approche duale garantit que les correspondances exactes et le contenu sémantiquement similaire sont pris en compte. Par exemple, lors de la recherche de "gestion d'erreurs", le système trouve les documents avec des correspondances exactes, mais identifie également le contenu lié à "gestion d'exceptions" ou "tolérance aux pannes".

Nous avons remplacé le reranker lourd (bge-reranker-v2-m3) par le reranker optimisé d'OpenAI. Ce changement a considérablement amélioré les temps de réponse tout en maintenant la qualité des résultats. Les utilisateurs reçoivent désormais des réponses en quelques secondes plutôt que d'attendre un traitement long.

Résultats

Les optimisations ont transformé OpenWebUI en un outil puissant pour interagir avec des bases documentaires propriétaires. Le système fournit désormais des résultats précis et pertinents qui aident les utilisateurs à trouver rapidement les informations dont ils ont besoin.

Améliorations clés :

Compréhension sémantique : Les utilisateurs peuvent désormais poser des questions en langage naturel, et le système comprend l'intention derrière leurs requêtes, pas seulement les correspondances de mots-clés. Par exemple, demander "Comment gérer les erreurs ?" récupère les sections pertinentes sur la gestion d'exceptions, la gestion d'erreurs et les procédures de dépannage.

Pertinence améliorée : La recherche hybride (BM25 + vecteurs) garantit que les correspondances exactes et le contenu sémantiquement lié apparaissent dans les résultats. Cela signifie que les utilisateurs trouvent des réponses complètes même lorsque la terminologie exacte diffère entre leur question et la documentation.

Réponses plus rapides : Le reranker optimisé a réduit considérablement les temps de réponse. Ce qui prenait auparavant 30-60 secondes se termine maintenant en moins de 5 secondes, améliorant considérablement l'expérience utilisateur.

Meilleure extraction du contexte : Le découpage optimisé (400/50) permet au système de récupérer précisément les bonnes sections de documents. Au lieu de renvoyer des documents entiers, les utilisateurs reçoivent des extraits ciblés qui répondent directement à leurs questions.

Correspondance sémantique de meilleure qualité : Le modèle d'embedding amélioré (1536 dimensions) capture mieux les relations entre concepts techniques, permettant une récupération plus précise d'informations liées.